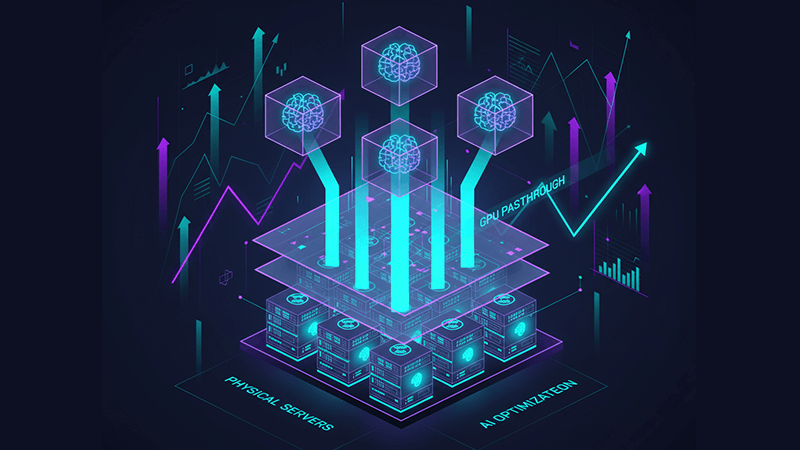

在虛拟化环境中部署 GPU Passthrough 以支持 AI

当 GPU 资源存在,却无法在合适的时间、合适的虚拟机中被有效使用时,AI 平台往往开始出现问题。一台虚拟机独占加速卡,另一台却长时间等待资源;模型训练因共享调度而出现不可预测的性能波动;虚拟化层在不知不觉中削弱了高价值 GPU 本应具备的性能。在这些情况下,基础设施并非完全失效,而是无法发挥应有的价值。GPU passthrough 虚拟化的目标,正是让虚拟化环境重新匹配 AI 工作负载的真实执行特性。

本文将深入解析 GPU passthrough 在 AI 工作负载中的实际运作方式、它与共享 GPU 模型之间的差异,以及基础设施选择如何影响长期的可扩展性与性能。

为什么 AI 工作负载会暴露传统 GPU 虚拟化的局限

AI 训练与高级推理在资源使用方式上,与传统企业应用存在本质差异。大型语言模型、推荐系统以及计算机视觉流水线,依赖的是对 GPU 显存的持续访问、稳定的 PCIe 带宽,以及长时间计算过程中的一致延迟表现。即便只是 GPU 调度或显存层面的轻微争用,也可能显著拉长训练时间,或为实时推理带来抖动。

用于 AI 训练的虚拟化 GPU 通常从 vGPU 或时间切片等共享模式起步。这类方式非常适合开发、测试以及中等规模的推理场景,因为资源利用率往往比极致性能更重要。然而,随着模型规模和显存需求不断增长,性能瓶颈往往不再来自 GPU 本身,而是来自虚拟化抽象层。

GPU passthrough 虚拟化通过将物理 GPU 直接分配给单一虚拟机,消除了这一限制。Hypervisor 不再介入 GPU 的执行与显存访问,来宾操作系统可以像在裸机上一样使用 GPU,从而恢复可预测的行为和接近原生的性能。

GPU Passthrough 虚拟化 与 虚拟 GPU 模型的差异

在 GPU passthrough 与共享 GPU 虚拟化之间做选择,是一种架构层面的判断,而非技术立场问题。两种模式各自适用于不同目标。

虚拟 GPU 模型,包括 NVIDIA vGPU 与软件时间切片,强调灵活性与资源密度。多台虚拟机可共享一张 GPU,因此非常适合以下场景:

- 虚拟桌面基础架构与远程可视化

- 开发环境与 CI 流程

- 轻量或突发型推理工作负载

- 多用户环境中以公平性为核心的场景

GPU passthrough 虚拟化则强调隔离性与性能。一台虚拟机完整占用一张 GPU,不存在显存超额分配、调度竞争或邻居干扰问题。这使其非常适合:

- AI 模型训练与微调

- 高性能计算与仿真

- 超出 vGPU 配置规格的高显存工作负载

- 对延迟高度敏感的推理流水线

在实际的 AI 平台中,这两种模式往往并行使用。Passthrough GPU 用于最关键、最重负载的任务,而共享 GPU 用于实验和规模化推理。

PCIe GPU Passthrough 与硬件架构

PCIe GPU passthrough 依赖于硬件级虚拟化技术,例如 Intel VT-d 或 AMD-Vi,统称为 IOMMU。这些技术允许 PCIe 设备被隔离,并直接映射到虚拟机的地址空间中。

为了让 passthrough 稳定、高效地运行,硬件层面需要满足多个条件:

- CPU 与芯片组必须支持 IOMMU

- BIOS 或 UEFI 正确暴露 IOMMU 分组

- 提供充足的 PCIe 通道以避免带宽争用

- NUMA 拓扑需正确对齐 CPU、内存与 GPU

NUMA 对齐常被低估。如果 GPU 所在的插槽与执行工作负载的 CPU 或内存位于不同节点,跨插槽通信带来的延迟,会显著削弱 passthrough 的性能优势。

电力与散热同样关键。通过 passthrough 分配的 GPU 往往长时间处于高负载状态。服务器级平台专为这种运行特性设计,而消费级系统在持续负载下更容易出现降频或稳定性问题。

Hypervisor 支持情况:VMware、KVM 与 OpenStack

主流 Hypervisor 均支持 GPU passthrough,但在实际部署中存在明显差异。

GPU passthrough VMware 环境通常通过 DirectPath I/O 实现。ESXi 拥有成熟的生态与稳定表现,但配置相对静态。一旦 GPU 分配给虚拟机,实时迁移、快照以及部分高可用功能将受到限制,因此更适合固定容量的 AI 训练节点。

GPU passthrough KVM 环境通过 Linux 内核层面的 VFIO 与 IOMMU 实现。KVM 在设备绑定、内核参数和 NUMA 布局方面提供高度可控性,因此广泛应用于研究集群、私有 AI 云以及高度定制化的环境。

OpenStack 在 KVM passthrough 基础上,结合 Nova 的 PCI passthrough 调度与 flavor 配置。虽然部署复杂度较高,但能够在大规模环境中实现多租户 GPU passthrough,并保持良好的隔离与资源管理能力。

Hyper-V 通过 Discrete Device Assignment 支持 GPU passthrough,但对虚拟机配置、内存管理和集群能力有更严格限制,因此在大规模 AI 场景中的灵活性相对较低。

GPU Passthrough 在 AI 工作负载中的运维取舍

GPU passthrough 带来的限制,需要在架构设计阶段就充分考虑。

启用 passthrough GPU 的虚拟机通常无法进行实时迁移,快照能力有限,硬件维护需要通过调度而非透明切换完成,驱动程序升级也必须在宿主机与来宾系统之间协调进行。

对于 AI 工作负载而言,这些取舍往往是可以接受的。模型训练通常是长时间运行、具备状态的任务,而推理服务通常在应用层进行副本与负载分担,而不是依赖虚拟机级别的高可用。作为交换,团队获得了可预测的性能、更清晰的问题定位,以及明确的资源归属关系。

超越单一 GPU 模式的 AI 平台扩展

采用 GPU passthrough 并不意味着架构变得僵化。对许多团队来说,它反而是建立性能基线的起点。

许多 AI 团队先通过 passthrough 确保关键训练任务达到接近裸机的性能,随着使用规模扩大,再逐步引入容器编排、MIG 分割,或为非关键任务建立共享 GPU 池。

现代 AI 基础架构通常同时结合:

- 用于训练和微调的 GPU passthrough

- 用于推理和开发的共享或分割 GPU

- 用于调度的 Kubernetes 或 OpenStack 平台

关键在于,让 GPU 的使用方式匹配具体工作负载,而不是让所有任务被迫采用同一种虚拟化模式。

Dataplugs GPU 独立服务器在 Passthrough 架构中的角色

GPU passthrough 虚拟化对基础设施质量高度敏感。资源过度共享、不透明的 PCIe 拓扑,以及受限的固件访问权限,都会削弱 passthrough 带来的性能优势。

Dataplugs GPU 独立服务器为 passthrough 部署提供了无需妥协的环境。这类服务器完整开放对计算、内存与 PCIe 拓扑的控制,使工程团队能够针对 AI 工作负载进行精细化调优。

支持 GPU passthrough 架构的关键特性包括:

- 专属使用的企业级 NVIDIA GPU

- 无超售的完整 PCIe 带宽

- 支持 IOMMU、VFIO 及自定义内核配置

- 适合 AI 训练的可预测 NUMA 架构

- 面向数据密集型流程的高速网络支持

由于资源不与其他租户共享,GPU passthrough for AI workloads 能长期保持一致的性能表现,使团队可以在同一平台上灵活组合 passthrough、共享 GPU 与编排框架,并随业务需求持续演进。

结论

在虚拟化环境中部署 GPU passthrough,本质上是让工作负载需求重新与硬件能力对齐。通过将 GPU 直接分配给虚拟机,企业可以移除多余的抽象层,恢复可预测的性能,并充分释放加速卡投资的价值。

当这种架构建立在能够全面掌控 PCIe 拓扑、内存布局与系统调优的独立基础设施之上时,GPU passthrough 不再是脆弱的例外,而是稳健可靠的基础。对于正在构建或扩展 AI 训练集群、推理平台或混合 GPU 环境的团队而言,这是一条兼顾当前性能与未来灵活性的路径。

如需了解专为 AI passthrough 架构设计的 GPU 独立服务器,欢迎访问 Dataplugs 官网,或通过在线聊天与 sales@dataplugs.com 与我们联系。