2026年最佳网络爬虫编程语言

随着数据成为企业决策和创新的核心,Web Crawling(网络爬虫)已经是自动化信息采集不可或缺的技术基础。不论是搜索引擎、价格监控、竞争情报还是合规审计,开发高效、可扩展、能应对动态网页的爬虫系统,选对开发语言至关重要。2026 年,Web Crawling 语言及生态持续进化,本文将全面剖析主流选择,深入比较实际应用,并探讨专业基础设施如何助力高效爬虫部署。

Web Crawling 是什么?核心机制解析

Web Crawling 即自动化程序根据规则递归访问网站,发现并采集大量网页内容。爬虫从一组种子 URL 出发,抓取页面、解析内容、提取新链接,不断扩展抓取范围,最终构建网站结构或多站点数据集。这个过程是搜索引擎收录、SEO 分析、实时市场研究背后的技术基础。

随着网页日益动态、API 盛行、反爬策略不断升级,选择合适的语言和技术栈,直接影响爬虫的稳定性、可维护性和扩展潜力。

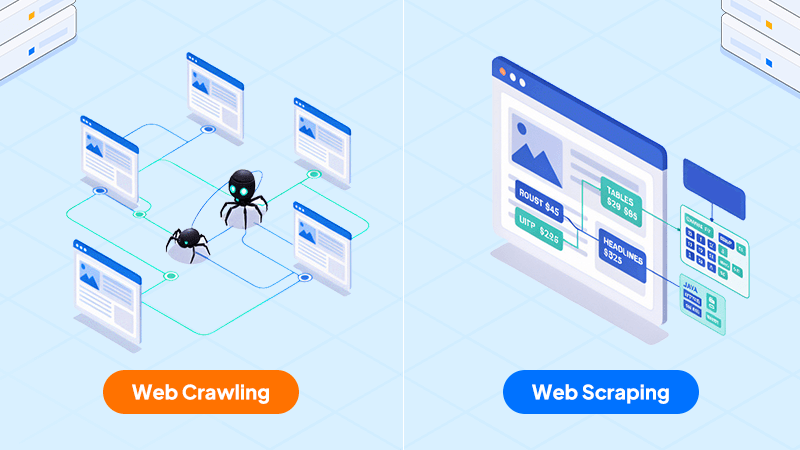

Web Crawling vs Web Scraping:功能定位与区别

Web Crawling 侧重自动发现和采集网页、建立 URL 地图;Web Scraping 则侧重于从已抓取的页面中提取特定结构化数据(如价格、标题、商品信息)。大多数企业级数据流程会结合两者:先用爬虫批量抓取页面,再用 Scraper 解析和结构化所需信息。分清这两个流程,有助于打造模块化、可持续扩展的数据平台。

主流 Crawling 语言实战对比与应用洞见

Python

Python 在爬虫开发领域长期占据主流,因其语法简洁、上手快、生态丰富。实战中,Scrapy 框架具备异步、事件驱动架构,高效管理分布式 URL 队列和数据管道,支持 XPath/CSS 精准选择和自定义中间件。生产环境常结合 Redis、RabbitMQ 做分布式任务调度,数据可入库 PostgreSQL/MongoDB 等。针对 JS 动态网页,Python 可配合 Selenium 或 Playwright 控制无头浏览器,实现完整渲染和数据提取。错误重试、流控、代理池等功能也可在 Scrapy 内部实现。Python 适合快速原型开发,也能胜任大规模部署。

Java

Java 在企业级、长时间运行的爬虫项目中极具竞争力。Apache Nutch 基于 Hadoop 架构支持大规模分布式爬取,支持自定义 URL 过滤、链接分析、实时去重。Jsoup 提供高效 HTML 解析和 CSS Selector 操作,适用于复杂 DOM 结构。实际部署中,Java 通常用线程池管理多线程 URL 抓取,也能集成企业认证(如 SSO)爬取受保护内容。JVM 监控工具便于分析性能瓶颈,内存管理优秀,适合追求高稳定、高吞吐、与旧系统集成的场景。

JavaScript(Node.js)

Node.js 特别适合现代 SPA、JS 动态网页的爬取需求。Puppeteer、Playwright 可自动化控制浏览器,模拟用户交互、等待 AJAX 加载、提取渲染后的 DOM。实战中常用 async/await 控制高并发,任务队列可用 Bull、Kue 等模块管理。静态页面可用 Cheerio 快速解析。Node.js 爬虫适合 Docker 容器化部署,易于弹性扩展。对于需频繁应对网页结构变动、动态内容丰富的项目,Node.js 表现尤为出色。

Go(Golang)

Go 近年来在高并发分布式爬虫领域表现突出。Goroutine 轻量线程可同时处理成千上万个 URL,Channel 机制让抓取、解析、存储协作流畅。Colly 框架支持代理池、Cookie 管理、重试机制,易于对接中间件。分布式部署常结合 NATS、Kafka 等消息队列管理负载。Go 编译后执行文件小、性能高,适用于云端和微服务架构。静态类型也有助于开发期错误提前发现,适合低延迟、高可预测性的应用场景。

Ruby

Ruby 以 Nokogiri(HTML/XML 解析)、Mechanize(Session 管理)等 gem 著称,适合重视代码可读性和快速开发的场景。实际操作中常用 Mechanize 处理登录、Cookie、浏览逻辑,Nokogiri 抽取内容。Ruby 的“约定优于配置”理念让爬虫脚本简洁易维护,尤其适合需求频繁变动、小型数据采集任务。虽然不如 Java、Go 适合大规模分布式爬取,但对注重开发效率的团队仍有吸引力。

PHP 和 C++

PHP 适合与现有 PHP 应用集成的简单爬虫,Guzzle、Symfony DomCrawler 等库可快速实现 HTTP 请求和内容解析。但由于缺乏原生多线程和 async 支持,不适合高并发任务。C++ 专注于极致高性能、低延迟场景(如专用硬件或嵌入式应用),常用 libcurl 处理网络请求、Gumbo 或 libxml2 解析,开发和维护成本较高,适合对资源掌控有极高要求的场景。

专业基础设施助力 Web Crawler 效能

无论选择哪种语言,底层基础设施的品质都直接影响爬虫的性能和稳定性。Dataplugs 的独立服务器方案,提供高带宽、独享 CPU/内存资源,满足持续、大规模爬行需求。对于需要分布式或资源密集型爬虫的团队,专用硬件可自定义防火墙规则、DDoS 防护和高效存储,保障合规和业务连续性。

使用独立服务器也便于安全策略实施,例如只开放必要的外连、实时监控流量异常,降低被封锁或检测的风险。

总结

2026 年,Web Crawling 编程语言的选择取决于实际需求、团队技术栈和业务规模。Python、Java、Node.js、Go 各有优势,只有结合合适的语言、架构设计和稳健基础设施,才能打造可扩展、易维护、高效的数据管道。如果你需要企业级爬虫系统部署支持,Dataplugs 独立服务器可为你的爬虫基础设施带来安全、弹性和专业性能。如需专业咨询,欢迎 Live Chat 或邮件 sales@dataplugs.com 与我们联系,让 Dataplugs 团队助你实现数据驱动的业务创新。