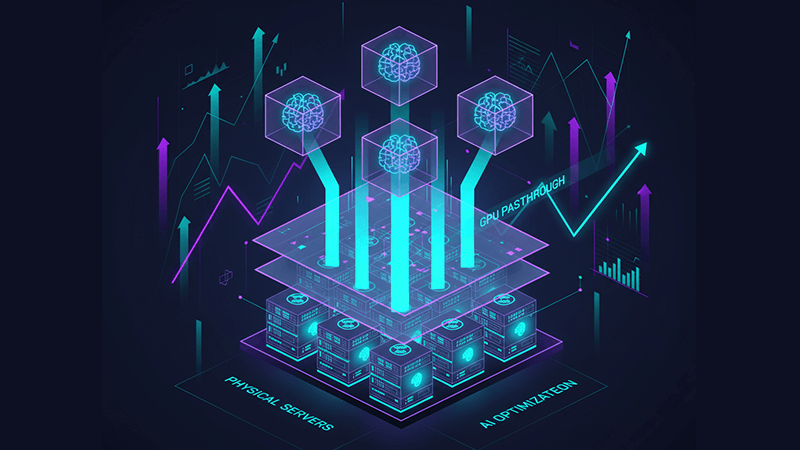

在虛擬化環境中部署 GPU Passthrough 以支援 AI

當 GPU 資源存在,卻無法在正確的時間、正確的虛擬機中被有效使用時,AI 平台往往開始出現問題。一台虛擬機獨佔加速卡,另一台卻長時間等待資源;模型訓練因共享排程而出現不可預期的速度波動;虛擬化層在不知不覺中侵蝕了高價 GPU 原本應有的效能。在這些情況下,基礎架構並非直接失效,而是無法發揮應有價值。GPU passthrough 虛擬化的目的,正是重新讓虛擬化環境與 AI 工作負載的實際執行特性對齊。

本文將深入說明 GPU passthrough 在 AI 工作負載中的實際運作方式、它與共享 GPU 模型的差異,以及基礎架構選擇如何影響長期的擴展性與效能。

為何 AI 工作負載會暴露傳統 GPU 虛擬化的極限

AI 訓練與進階推論的運作方式,與傳統企業應用截然不同。大型語言模型、推薦系統與電腦視覺流程,仰賴的是對 GPU 記憶體的持續存取、穩定的 PCIe 頻寬,以及長時間運算過程中的一致延遲表現。即使只是 GPU 排程或記憶體層級的輕微競爭,都可能大幅拉長訓練時間,或為即時推論帶來抖動。

虛擬化 GPU 用於 AI 訓練時,往往從 vGPU 或時間切片等共享模式開始。這類模式非常適合開發環境、測試場景,以及中等規模的推論工作負載,因為資源利用率比極致效能更重要。然而,隨著模型參數數量與記憶體需求不斷成長,限制效能的往往不再是 GPU 本身,而是虛擬化抽象層。

GPU passthrough 虛擬化透過將實體 GPU 直接指派給單一虛擬機,移除了這層限制。Hypervisor 不再介入 GPU 的執行與記憶體存取,來賓作業系統可以像在裸機上運作一樣使用 GPU,重新取得可預期的行為與接近原生的效能。

GPU Passthrough 虛擬化 與 虛擬 GPU 模型的差異

在 GPU passthrough 與共享 GPU 虛擬化之間做選擇,是架構層面的決策,而非單純技術偏好。兩者各自服務不同的目標。

虛擬 GPU 模型,包括 NVIDIA vGPU 與軟體式時間切片,強調彈性與密度。多台虛擬機可同時共享一張 GPU,因此非常適合:

- 虛擬桌面基礎架構與遠端視覺化

- 開發與 CI 流程

- 輕量或突發型推論工作負載

- 多使用者環境中以公平性為主的場景

GPU passthrough 虛擬化則專注於隔離性與效能。一台虛擬機完整擁有整張 GPU,不存在記憶體超額配置、排程競爭或鄰居干擾問題。這使其特別適合:

- AI 模型訓練與微調

- 高效能運算與模擬

- 超出 vGPU 設定檔的高記憶體需求工作負載

- 對延遲高度敏感的推論流程

在實際的 AI 平台中,這兩種模式經常並存。Passthrough GPU 負責最關鍵的高負載任務,而共享 GPU 則支援實驗與規模化推論。

PCIe GPU Passthrough 與硬體架構

PCIe GPU passthrough 仰賴硬體層級的虛擬化技術,例如 Intel VT-d 或 AMD-Vi,統稱為 IOMMU。這些功能讓 PCIe 裝置可以被隔離,並直接映射至虛擬機的位址空間。

要讓 passthrough 穩定且高效運作,硬體條件至關重要:

- CPU 與晶片組必須支援 IOMMU

- BIOS 或 UEFI 需正確暴露 IOMMU 群組

- 必須有足夠的 PCIe 通道避免頻寬競爭

- NUMA 拓撲需正確對齊 CPU、記憶體與 GPU

NUMA 對齊經常被低估。如果 GPU 所在的插槽與執行工作負載的 CPU 或記憶體位於不同節點,跨插槽傳輸所帶來的延遲,可能抵銷 passthrough 帶來的大部分效能優勢。

電力供應與散熱同樣關鍵。透過 passthrough 指派的 GPU 往往長時間處於高使用率狀態。伺服器等級平台專為此類負載設計,而一般消費級系統在長時間運作下可能出現降頻或不穩定。

Hypervisor 支援情況:VMware、KVM 與 OpenStack

主流 Hypervisor 均支援 GPU passthrough,但實務上的差異不容忽視。

GPU passthrough VMware 環境通常透過 DirectPath I/O 實作。ESXi 生態成熟、行為可預期,但設定偏向靜態。一旦 GPU 指派給虛擬機,Live Migration、快照與部分高可用功能將受到限制,因此較適合固定容量的 AI 訓練節點。

GPU passthrough KVM 環境則透過 Linux 核心層級的 VFIO 與 IOMMU 實現。KVM 提供對裝置綁定、核心參數與 NUMA 配置的高度控制,因此在研究型叢集、私有 AI 雲與高度客製化環境中非常常見。

OpenStack 在 KVM passthrough 基礎上,透過 Nova 的 PCI passthrough 排程與 flavor 設定進行管理。雖然配置複雜度較高,但能在大規模環境中實現多租戶 GPU passthrough,兼顧隔離性與資源控管。

Hyper-V 透過 Discrete Device Assignment 支援 GPU passthrough,但對虛擬機設定、記憶體管理與叢集功能有較嚴格限制,因此在大規模 AI 場景中的彈性較低。

GPU Passthrough 在 AI 工作負載中的營運取捨

GPU passthrough 帶來的限制,需要在設計階段就納入考量。

配有 passthrough GPU 的虛擬機通常無法進行即時遷移,快照功能有限,硬體維護需透過排程而非透明切換,驅動程式更新也必須同步處理主機與來賓系統。

對 AI 工作負載而言,這些取捨往往是可接受的。模型訓練通常是長時間、具狀態的流程,而推論服務多半在應用層進行複本與負載分散,而非依賴虛擬機層級的高可用性。作為交換,團隊獲得的是可預期的效能、更清晰的問題定位,以及明確的資源歸屬。

超越單一 GPU 模型的 AI 平台擴展

採用 GPU passthrough 並不代表架構走向僵化。對許多團隊來說,它反而是建立效能基準的第一步。

許多 AI 團隊先透過 passthrough 確保關鍵訓練工作負載達到裸機等級效能,隨著需求成長,再逐步引入容器編排、MIG 分割,或為非關鍵任務建立共享 GPU 資源池。

現代 AI 基礎架構通常同時結合:

- GPU passthrough 用於訓練與微調

- 共享或分割 GPU 用於推論與開發

- Kubernetes 或 OpenStack 等平台進行排程

關鍵在於,讓 GPU 存取模型符合工作負載本身的需求,而不是將所有任務強行套用同一種虛擬化方式。

Dataplugs GPU 專屬伺服器在 Passthrough 架構中的角色

GPU passthrough 虛擬化對基礎架構品質極為敏感。資源過度共享、不透明的 PCIe 拓撲,以及受限的韌體存取權,都會削弱 passthrough 帶來的效能優勢。

Dataplugs GPU 專屬伺服器提供一個不需妥協的環境,讓 passthrough 能穩定部署。這類伺服器完整暴露對運算、記憶體與 PCIe 拓撲的控制權,工程師可針對 AI 工作負載進行精細調校。

支援 GPU passthrough 架構的關鍵特點包括:

- 專屬使用的企業級 NVIDIA GPU

- 無超額配置的完整 PCIe 頻寬

- 支援 IOMMU、VFIO 與自訂核心設定

- 適合 AI 訓練的可預期 NUMA 佈局

- 支援高資料吞吐的高速網路

由於資源不與其他租戶共享,GPU passthrough for AI workloads 能長期保持一致表現,讓團隊在同一平台上同時使用 passthrough、共享 GPU 與編排框架,並隨需求演進。

結論

在虛擬化環境中部署 GPU passthrough,核心在於重新對齊工作負載需求與硬體能力。透過將 GPU 直接指派給虛擬機,企業得以移除不必要的抽象層,重獲可預期效能,並充分發揮加速卡投資的價值。

當這樣的架構搭配能完整掌控 PCIe 拓撲、記憶體配置與系統調校的獨立基礎架構時,GPU passthrough 不再是脆弱的特例,而是穩定可靠的基石。對於正在設計或擴展 AI 訓練叢集、推論平台或混合 GPU 環境的團隊而言,這是一條兼顧當下效能與未來彈性的路徑。

如需了解專為 AI passthrough 架構打造的 GPU 專屬伺服器,歡迎造訪 Dataplugs 官網,或透過即時聊天與 sales@dataplugs.com 聯絡我們。