2026年最佳網絡爬蟲程式語言

隨著數據成為企業決策與創新的引擎,Web Crawling(網絡爬蟲)已成為自動化資訊蒐集不可或缺的技術核心。無論是搜尋引擎、價格監測、競爭情報還是合規稽核,開發高效、可擴展且能應對動態網頁的爬蟲系統,選擇合適的開發語言尤為關鍵。2026 年,Web Crawling 語言及其生態已進化至新高度,本文將全面剖析主流選擇,深入比較實戰應用,並探討專業基礎設施如何支撐高效爬蟲部署。

Web Crawling 是什麼?核心運作機制解析

Web Crawling 即自動化程式根據預設規則,遞迴瀏覽網站、發現並蒐集大量網頁內容。爬蟲從一組初始種子網址出發,擷取頁面、解析內容、追蹤新連結,不斷擴展抓取範圍,最終構建出網站結構或跨站資料集。這一過程是搜尋引擎索引、SEO 分析、即時市場研究背後的技術支柱。

隨著網頁日益動態、API 盛行、反爬策略不斷進化,選擇合適語言與技術棧,將直接影響爬蟲的穩定性、可維護性與擴展潛力。

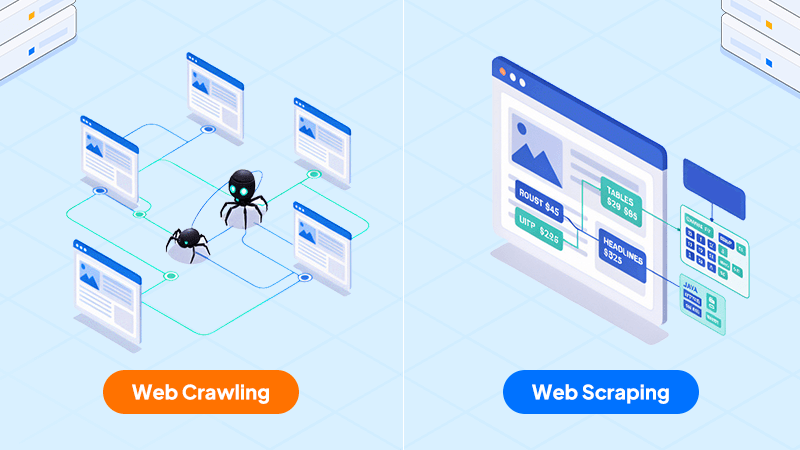

Web Crawling vs Web Scraping:功能定位與區別

Web Crawling 著重於自動發現與收集網頁、建立網址地圖;Web Scraping 則著重於從已取得頁面中萃取特定結構化資料(如價格、標題、商品資訊)。大部分企業級數據管道會結合兩者:先用爬蟲抓取大量頁面,再用 Scraper 解析並結構化所需資訊。清楚區分這兩個工作流程,有助於打造模組化、可持續擴充的數據平台。

主流 Crawling 語言實戰比較與應用洞見

Python

Python 在爬蟲開發領域長期穩居主流,原因在於其語法簡潔、學習曲線平緩與豐富的生態系。實際應用上,Scrapy 框架具備非同步、事件驅動架構,能高效管理分散式 URL 佇列與資料管道,支援 XPath/CSS 精準選取與自訂中介層。大型生產環境常見結合 Redis、RabbitMQ 做分散式任務協調,資料存取可串接 PostgreSQL/MongoDB 等多種儲存。針對 JS 動態網頁,Python 可搭配 Selenium 或 Playwright 控制無頭瀏覽器,實現完整渲染與資料萃取。錯誤重試、流量管控、代理池等機制皆可在 Scrapy 內部實現。Python 不僅適合快速原型開發,更能支援大規模部署。

Java

Java 在企業級、長時運行的爬蟲專案極具競爭力。Apache Nutch 透過 Hadoop 架構可大量分散式爬行,支援自訂 URL 過濾、連結分析、實時重複資料排除。Jsoup 提供高效 HTML 解析與 CSS Selector 操作,適合複雜 DOM 結構處理。生產實務上,Java 常用 ThreadPool 管理多線程 URL 抓取,亦能整合企業認證(如 SSO)爬取受保護內容。JVM 監控工具協助分析效能瓶頸,記憶體管理佳,適合需高穩定、高吞吐且整合舊有系統的情境。

JavaScript(Node.js)

Node.js 特別適合現代 SPA、JS 動態網頁的爬行需求。Puppeteer、Playwright 可無縫自動化瀏覽器,模擬用戶互動、等待 AJAX 載入、萃取渲染後的 DOM。實務實現上,開發人員常以 async/await 控制數千個並發連線,佇列管理可交由 Bull、Kue 等模組協調。靜態頁面則可用 Cheerio 快速解析。Node.js 爬蟲適合 Docker 容器化部署,易於彈性擴充。對於需頻繁應對網頁結構變化、動態內容繁多的專案,Node.js 展現高度適應力。

Go(Golang)

Go 近年在高並發分散式爬蟲領域異軍突起。Goroutine 輕量級線程可同時處理成千上萬個 URL,Channel 機制讓爬行、解析、儲存三者協作流暢。Colly 框架支援代理池、Cookie 管理、重試機制,易於串接中介軟件。分散式部署常見結合 NATS、Kafka 等訊息佇列管理負載。Go 編譯後的執行檔體積小、效能高,部署在雲端或微服務架構尤為便利。靜態型別設計亦有助於開發期錯誤提前檢查,適合強調低延遲與高可預測性的應用。

Ruby

Ruby 以 Nokogiri(HTML/XML 解析)、Mechanize(Session 管理)等 gem 著稱,適合重視程式可讀性與快速開發的場景。實際操作中常用 Mechanize 處理登入、Cookie、瀏覽邏輯,Nokogiri 負責標籤選取與資料抽取。Ruby 的「慣例大於設定」精神,使爬蟲腳本簡潔易維護,尤其適合專案頻繁變動、小型數據蒐集任務。雖然不如 Java、Go 適合大規模分散式爬行,但對於強調開發效率的團隊仍具吸引力。

PHP 與 C++

PHP 適用於需與既有 PHP 應用整合的簡易爬蟲,Guzzle、Symfony DomCrawler 等函式庫可快速實現 HTTP 請求與內容解析。但由於缺乏原生多線程與 async 支援,不適合高並發任務。C++ 則屬極端高效能、低延遲場景(如專用硬件或嵌入式應用)的選擇,常用 libcurl 處理網路請求、Gumbo 或 libxml2 進行解析,開發與維護成本較高,專屬於對資源掌控有極高要求的情境。

專業基礎設施加速 Web Crawler 效能

無論選擇哪種語言,底層基礎設施品質將直接影響爬蟲效能與穩定性。Dataplugs 的專屬伺服器方案,提供高頻寬、獨立 CPU/記憶體資源,滿足持續、大規模爬行需求。對於需部署分散式或資源密集型爬蟲團隊,專用硬體可自訂防火牆規則、DDoS 防護與高效儲存,確保合規與營運不中斷。

採用專屬伺服器同時有助於安全設計,例如僅開啟必要的對外連線、即時監控流量異常,降低被封鎖或偵測風險。

總結

2026 年,Web Crawling 語言選擇將隨著應用需求、團隊技術棧與業務規模而異。Python、Java、Node.js、Go 各擅勝場,唯有結合正確語言、架構設計與穩健基礎設施,才能打造可擴展、易維護且高效的數據管道。若您需要支援企業級爬蟲專案部署,Dataplugs 專屬伺服器可為您的爬蟲基礎設施帶來安全、彈性與專業效能。如需專業諮詢,歡迎即時 Live Chat 或電郵 sales@dataplugs.com 與我們聯繫,讓 Dataplugs 團隊協助您推動數據驅動的業務創新。